Meta Set Block Decoding技术:LLM推理提速3-5倍的算法优化方案

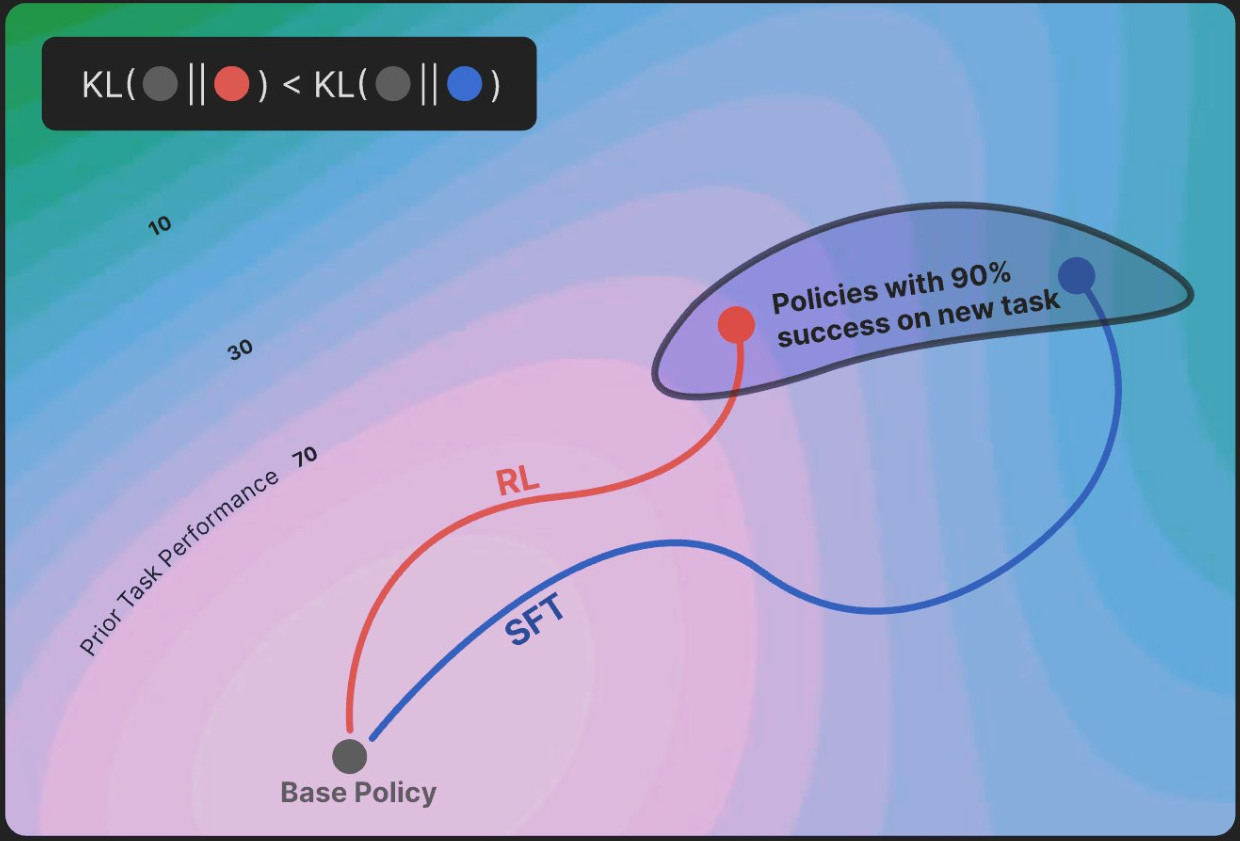

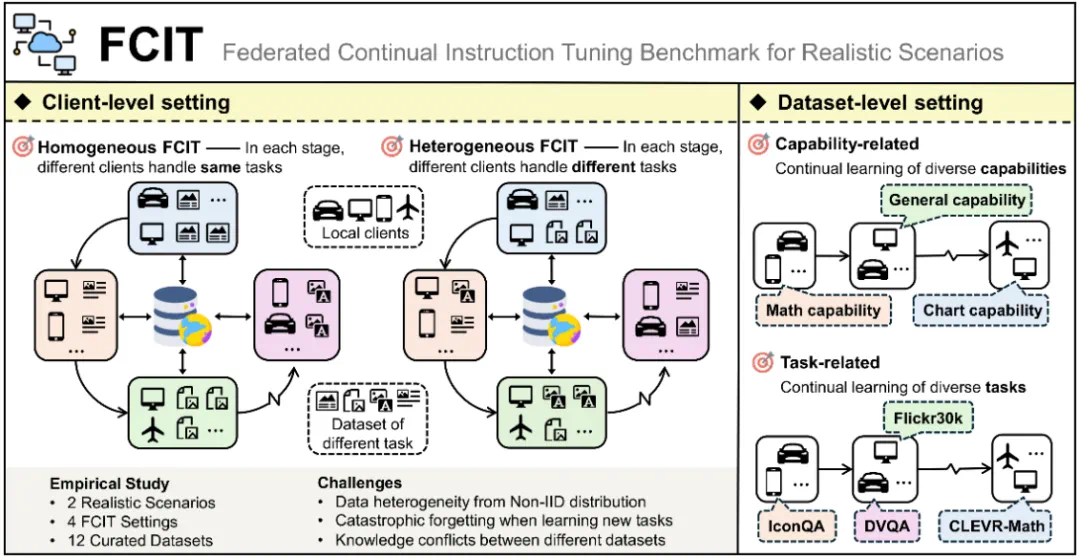

大语言模型(LLM)推理速度慢是当前用户体验核心痛点,传统自回归解码因串行计算和重复计算键值对导致效率低下。Meta推出的Set Block Decoding技术通过算法优化,实现推理速度3-5倍提升,且无需修改模型架构、重训练或更换硬件,即插即用适配现有部署。其核心优化包括键值缓存分块复用(减少30%以上重复计算)和块级并行解码(硬件并行执行提升效率)。该技术显著改善实时交互场景(客服、教育、医疗秒级响应)、生成式AI工具(创作效率提升3-5倍),并降低中小企业使用门槛。作为LLM推理优化里程碑,它以算法创新推动行业从“堆资源”转向“提效率”,兼容主流模型,有望成为推理标配,加速AI普惠化落地。