大语言模型[119]

全球最快开源大模型K2 Think推出:推理速度突破2000 tokens/秒,刷新性能纪录

K2 Think开源大模型发布,推理速度突破2000 tokens/秒(最高2730.4),成已知最快开源大模型之一。基于通义千问Qwen 2.5-32B架构,数学推理表现优异(AIME’24得分90.83),依托六大技术创新支撑高速与精准。基于通义千问架构,已在HuggingFace等开源平台发布,助力AI技术普及。

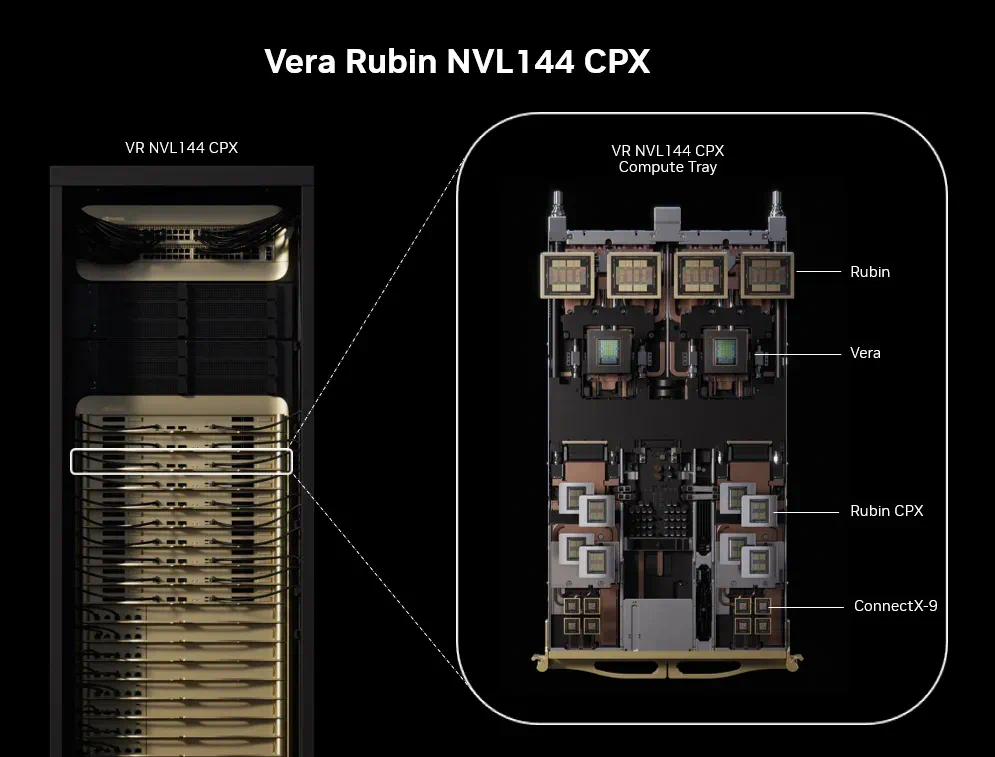

英伟达发布突破性Rubin CPX GPU:重塑百万级长上下文AI推理

英伟达推出专为百万级长上下文推理设计的Rubin CPX GPU,采用解耦式架构与长序列处理单元(LSPU),实现3倍注意力机制处理速度,端到端延迟降低40%、能耗下降55%。其128GB GDDR7内存与动态资源分配技术,赋能代码生成、法律研究、长视频分析等场景,重塑AI推理基础设施,预计2026年底上市。

ETH与MATS发布突破性研究:实时检测AI长文本实体幻觉 筑牢高风险领域安全防线

大模型“幻觉”问题制约医疗、法律等高风险领域应用,ETH与MATS团队提出创新实时检测方案。该方法突破传统局限,实现实体级精准识别,低成本实时标记错误实体,无需昂贵外部验证,支持700亿参数模型。可提升AI生成内容可靠性,相关数据集与代码已开源,助力高风险领域安全应用。

华为开源7B模型:快慢思考自适应 精度不减思维链缩短近50%

华为开源openPangu-Embedded-7B-v1.1大模型,创新“双重思维引擎”实现快慢思考自适应切换,采用渐进式微调训练。权威评测显示,通用任务(CMMLU)、数学难题(AIME)等精度提升超8%,思维链长度缩短近50%,效率精度双提升,同步推出1B边缘模型,开源推动行业创新。

杜克大学陈怡然团队DPad方法:破解扩散大模型全局规划与效率两难,实现61倍加速

扩散大语言模型(dLLM)凭借全局规划能力在长文本生成等任务中表现突出,但因需对未来文本进行双向注意力计算,存在计算冗余、推理速度慢的痛点。杜克大学陈怡然团队提出的DPad方法,通过动态窗口聚焦近处关键“草稿纸”(后缀token)、先验丢弃远处冗余信息,实现效率与规划的平衡。该方案无需训练即可即插即用,在主流dLLM上实现61倍推理加速,精度损失不足0.5%,为实时长文本生成、边缘设备部署等场景扫清障碍,推动扩散模型工业化落地。

OpenAI技术双星Pachocki与Sidor:塑造AI巨头的关键路径

OpenAI CEO Sam Altman公开赞扬的“技术双星”Jakub Pachocki与Szymon Sidor,是OpenAI技术大厦的核心奠基者。二人分别主导算法突破与工程落地,从Dota 2项目验证强化学习规模化潜力,到GPT-4研发中实现参数量优化、推理效率跃升等关键突破,推动OpenAI技术边界扩张。2023年OpenAI“宫斗”事件中,他们联合技术团队以辞职施压,逆转董事会决策,彰显技术骨干话语权。而用户对ChatGPT标准语音退役、GPT-4o缩减服务的抗议,则折射出AI巨头在技术迭代与用户情感体验间的平衡挑战。这对“传奇搭档”的故事,既是AI技术狂飙突进的缩影,也为行业提供技术突破与用户需求协同的启示。

Unsloth框架:重新定义开源LLM微调的效率与稳定性标准

Unsloth作为新兴开源LLM微调框架,凭借内存优化技术与主流模型缺陷修复能力,重新定义本地化训练标准:在A100显卡上实现Llama-3 8B模型训练速度提升3.2倍、显存占用减少80%,且零精度损失。其通过OpenAI Triton内核重构计算模块,结合分层梯度检查点与4-bit量化技术,将Llama-3.1-8B微调显存需求从48GB降至12GB,使消费级RTX 4090也能胜任专业卡任务。团队深度参与开源生态,已修复Qwen3 128K上下文崩溃、Phi-3位置编码偏移等主流模型缺陷,相关补丁被llama.cpp、Microsoft等项目采纳。支持微调与RLHF一体化流程,广泛应用于法律科技(如LexNex合同分析)、电商客服(如ShopBot回复优化)等领域,经社区验证内存优化效果显著,有效降低中小团队AI个性化成本门槛。

蚂蚁集团AQ-MedAI提出DIVER框架:RAG技术从关键词匹配迈向逻辑链推理

传统RAG技术依赖关键词匹配,在医学诊断、数学证明等复杂任务中难以挖掘深度逻辑关联。为此,BRIGHT基准应运而生,聚焦推理密集型检索评价。蚂蚁集团提出DIVER框架,通过“预处理→查询扩展→推理检索→重排序”四阶段协同,将推理嵌入检索全流程,实现从关键词到逻辑链的跨越。该框架登顶BRIGHT基准,nDCG@10得分45.8,在医学、数学、编程等场景显著提升检索准确率,且泛化性强。目前论文、代码及模型已开源,助力AI从信息匹配迈向逻辑推理,赋能医疗辅助诊断、教育解题等领域发展。

百度文心大模型X1.1发布:三大核心能力跨越式提升,技术突破落地多场景

2025年WAVE SUMMIT大会上,百度发布文心大模型X1.1,实现事实性准确率提升34.8%、指令遵循优化12.5%、智能体能力增强9.6%,整体表现比肩GPT-5与Gemini 2.5 Pro。实测中,模型在逻辑推理(如"星球版农夫过河"问题)、事实检验(郑和下西洋伪史纠偏)、智能体多工具协同(小红书露营文案生成)等场景展现强落地能力。技术上采用混合强化学习与自蒸馏数据闭环,叠加思维链+行动链等三大模块强化推理与执行精度。同步升级的飞桨3.2框架,训练MFU达47%、推理2比特压缩降本增效,开源ERNIE-4.5-21B支持中小团队低成本开发。飞桨开发者超2333万,推动AI技术普惠与行业应用落地。

MIT团队DSPy框架:以模块化编程重塑LLM应用开发流程

DSPy框架是MIT主导的开源LLM应用开发工具,以“签名式编程”为核心,通过结构化代码替代传统提示词工程,显著提升复杂AI任务开发效率。其“签名-模块-优化器”三位一体架构,支持任务接口标准化(签名定义输入输出)、LLM调用逻辑封装(内置ChainOfThought、ReAct等模块)及自动化性能优化(如BootstrapFewShot、GEPA等工具),解决了提示词碎片化、系统难维护等痛点。GEPA框架结合遗传算法与帕累托优化,实现多目标(准确率、延迟等)平衡,适用于客服智能体等复杂场景。实战案例Support-Sam客服智能体基于DSPy构建,以不足200行代码实现工单分类、知识库检索等全流程自动化。目前,Shopify、DeepLearning.AI等机构已将其用于生产环境,推动LLM应用开发从“作坊式调优”迈向工程化、模块化新阶段。